먼저 보고올 개념

분산

정의

확률변수 X에 대한

기대값 $\mu = E(X)$

분산 $Var(X) = E((X-\mu)^2)$

즉 평균에서 얼마나 떨어졌는지를 나타내는 편차의 제곱을 평균낸것

의미

평균에서 표본들이 얼마나 떨어져있는지의 정도를 나타낸다고 보면 된다. 분산이 크면 말그대로 평균에서 멀리 멀리 떨어져들 있어서 변동성이 심한 것

공분산

공분산은 식은 매우 간단한 편이고, 의미를 이해하는데 난이도가 있다.

여기 링크 좋다.

정의

확률변수가 이번엔 두개 등장.. X와 Y

각각의 평균에 해당하는 기대값은 다음과 같다.

$$E(X) = \mu, E(Y) = \nu$$

뒤에 v처럼 생긴건 뉴라고 읽는다.

이때 공분산은 다음과 같이 나타낼 수 있다.

$$Cov(X, Y) = E((X-\mu)(Y-\nu))$$

분산과 비교해보면 분산에서는 하나의 확률변수에 대한 표본과 평균의 차이를 제곱하는데($E((X-\mu)^2)$)

공분산에서는 대신에 두개의 확률변수에 대한 표본과 평균의 차이를 곱해준 형태이다.

다르게 표현하자면 공분산은 X의 편차와 Y의 편차를 곱한것의 평균이 된다.

여기서 반드시 가져야할 의문은, 위처럼 하면 왜 X와 Y의 관계를 나타내주는가 하는 점과

X와 Y의 관계를 나타내는데 있어서는 위의 식이 아니라 다른 형태의 식으로도 가능한거 아니야?

라는 질문이 반드시 나와야 한다.

학자들이 결론낸걸 외우기만 해서는 아무 의미가 없다.

그냥 공분산이 아~ 저런식이고 저런의미를 갖는구나~ 하고 인정하고 넘어가지말고

분산에서 공분산으로 넘어가는 과정에서 왜 반드시 위의 식이 유일한 솔루션이 되었는가를 파해치는게 중요하다.

식을 전개해보면 다음과 같이 된다.

$$Cov(X,Y)=E((X-\mu)(Y-\nu))=E(XY)-\mu\nu$$

이산확률변수에 대해서 기대값을 제거한 식을 써보면 다음과 같다.

$$Cov(X,Y) = {{1\over n} \sum_{i=1}^n{(x_i-E(X))(y_i-E(Y))}}$$

분산에서와 마찬가지로 표본공분산을 구할때는 n이 아니라 n-1로 나눠줘야 한다.

의미

두 변수 사이의 관계를 나타냄

$Cov(X, Y) > 0$ X가 증가 할 때 Y도 증가한다.

$Cov(X, Y) < 0 $ X가 증가 할 때 Y는 감소한다.

$Cov(X, Y) = 0 $ X와 Y는 서로 독립

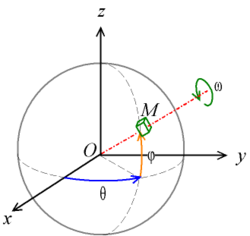

위 그림을 보고 식과 연관지어 생각해보자. 어떤 샘플이 $\mu$에 대해서도 양의 편차를 가지고 $\nu$에 대해서도 양의 편차를 가지면 위 그래프에서 1사분면에 점이 찍히게 된다.

평균은 어차피 중간쯤으로 정해져 있지만 X가 양의 편차일때 Y도 양의 편차, X가 음의 편차일때 Y도 음의편차를 가지는 식이 되면 공분산이 커진다는 것

상관계수

위 공분산의 문제점은 원본데이터의 평균이나 편차에 대해서 정규화가 안된 값이다 보니 서로 비교하기가 어렵다는 점이다.

따라서 공분산을 그 크기(?)로 나눠주는 식으로 정규화(?)하면 그것이 바로 상관계수가 되고 그 식은 다음과 같다.

(아래식은 피어슨 상관계수 (Pearson correlation coefficient)이며 다르게 정의된 상관계수도 있다.)

공분산을 각자의 표준편차의 곱으로 나눠주면 된다.

$$\rho_{X,Y}= \frac{\operatorname{cov}(X,Y)}{\sigma_X \sigma_Y}$$

주요 성질은 다음과 같다.

1. 상관계수의 절대값은 1을 넘을 수 없다.

2. 확률변수 X, Y가 독립이라면 상관계수는 0이다.

3. X와 Y가 선형적 관계라면 상관계수는 1 혹은 -1이다.

공분산과 개념적으로는 같고 수치만 절대값 1이내로 정규화됐다고 보면 될 것 같다.

공분산의 성질

내적과 유사하다

이거 전에 어디서 봤는데.. 다시 찾아서 정리하자.

여기였구나. 공분산이 아니라 상관관계구나

'수학' 카테고리의 다른 글

| 베이즈 추론(Bayesian inference) (0) | 2019.06.27 |

|---|---|

| Bootstrap Sampling(부트스트랩 샘플링) (0) | 2019.02.08 |

| 확률변수(random variable) (0) | 2019.01.18 |

| 직교행렬(orthogonal matrix) (0) | 2019.01.09 |

| 고유값, 고유벡터(eigenvalue and eigenvector) (0) | 2019.01.09 |

![{\displaystyle {\begin{alignedat}{1}R_{x}(\theta )&={\begin{bmatrix}1&0&0\\0&\cos \theta &-\sin \theta \\[3pt]0&\sin \theta &\cos \theta \\[3pt]\end{bmatrix}}\\[6pt]R_{y}(\theta )&={\begin{bmatrix}\cos \theta &0&\sin \theta \\[3pt]0&1&0\\[3pt]-\sin \theta &0&\cos \theta \\\end{bmatrix}}\\[6pt]R_{z}(\theta )&={\begin{bmatrix}\cos \theta &-\sin \theta &0\\[3pt]\sin \theta &\cos \theta &0\\[3pt]0&0&1\\\end{bmatrix}}\end{alignedat}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a6821937d5031de282a190f75312353c970aa2df)