'수학' 카테고리의 다른 글

| 모듈러연산 (0) | 2020.04.04 |

|---|---|

| 베이즈 추론(Bayesian inference) (0) | 2019.06.27 |

| Bootstrap Sampling(부트스트랩 샘플링) (0) | 2019.02.08 |

| 공분산(Covariance)과 상관계수(Correlation Coefficient) (0) | 2019.01.18 |

| 확률변수(random variable) (0) | 2019.01.18 |

| 모듈러연산 (0) | 2020.04.04 |

|---|---|

| 베이즈 추론(Bayesian inference) (0) | 2019.06.27 |

| Bootstrap Sampling(부트스트랩 샘플링) (0) | 2019.02.08 |

| 공분산(Covariance)과 상관계수(Correlation Coefficient) (0) | 2019.01.18 |

| 확률변수(random variable) (0) | 2019.01.18 |

1.[(a mod n)+(b mod n)] mod n = (a+b) mod n

2.[(a mod n)-(b mod n)] mod n = (a-b) mod n

3.[(a mod n)*(b mod n)] mod n = (a*b) mod n

위처럼 덧셈 뺄셈 곱셈에 대해서는 대체로 마구 적용해도 된다.

나눗셈에 대해서는 적용안되는것 주의

일반적인 덧셈 말고 concatenation의 경우는 조심해야한다.

예를 들어 38과 427이 있을때 이 둘을 이어붙이 38427이라는 숫자에 대해서 mod 연산을 한다고 해보자.

$38 \times 10^3 + 427$ 이므로 $(38 \mod K) * (10^3 \mod K) + (427 \mod K)$ 이런건 가능하다..

만약 K가 8라고 한다면 $(38 \mod 8)*(10^3 \mod 8)+(427 \mod 8) = 6*0+3 = 3$이고

$3 \mod K=3$인데 원래수인 $38427 \mod K=3$이므로 같은 걸 알수 있다.

그런데 $38 \mod 8=6$이고 $427 \mod 8=6$라고 해서 6과 6를 이어붙여서(concatenation) 66로 만들게 되면 $66 \mod K=2$이므로 같지 않은걸 알 수 있다.

이 문제에서 해당 부분을 연습할 수 있다.

| 수학관련 유용한 사이트 (0) | 2024.01.27 |

|---|---|

| 베이즈 추론(Bayesian inference) (0) | 2019.06.27 |

| Bootstrap Sampling(부트스트랩 샘플링) (0) | 2019.02.08 |

| 공분산(Covariance)과 상관계수(Correlation Coefficient) (0) | 2019.01.18 |

| 확률변수(random variable) (0) | 2019.01.18 |

여기 참조

이항분포처럼 확률이 정해진 독립사건을 여러번 시행했을때를 다룬다. (예를 들면 동전이나 주사위)

베르누이는 이항분포의 특수한 사례에 속하며 이항분포에서 반복실험 횟수 n에 1을 대입하면 베르누이분포가 된다.

동전을 던졌을때 앞면이 나올 확률을 $\theta$라고 하고, 앞면이 나오는 사건을 y=1, 뒷면이 나오는 사건을 y=0으로 표기하면

동전의 앞면이 나올 확률은 $p(y=1|\theta)=\theta$가 되고 뒷면이 나올 확률은 $p(y=0|\theta)=1-\theta$가 됨을 알 수 있다.

앞면뒷면 사건을 1,0으로 정의한 덕분에 동시에 합쳐서 다음과 같이 표현할 수 있다.

$$p(y|\theta) = \theta^y(1-\theta)^{(1-y)}$$

위식이 바로 베르누이 분포를 나타낸다.

성공과 실패두가지 밖에 없으므로 이산확률분포가 되며 그 모양은 여기를 참조

동전 던지기 N번 실행해서 z번 앞면이 나오는 경우는 다음처럼 표현이 가능하다.

$$p(z,N|\theta) = \theta^z(1-\theta)^{(N-z)}$$

| 베타함수, 베타분포 (0) | 2019.06.27 |

|---|---|

| 깁스 샘플링(Gibbs Sampling) (0) | 2019.06.26 |

| 카이제곱 검정(chi-squared test) (0) | 2019.06.21 |

| 정규분포 (1) | 2019.06.20 |

| 가설검정, 유의수준, 귀무가설, 대립가설, p-value(p값), t-test(t검정), z-test(z검정) (0) | 2019.04.26 |

여기 참조

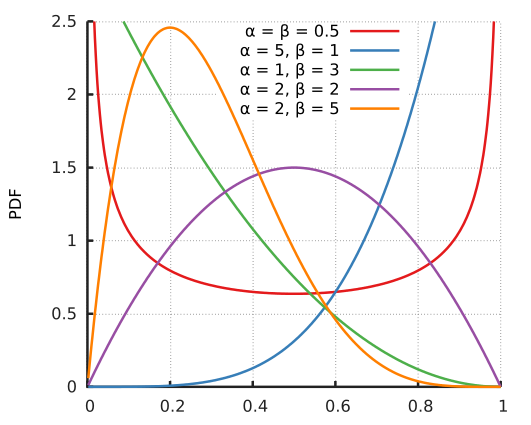

베타분포는 베르누이분포의 모수(모델 또는 파라미터) $\theta$를 추정하는데 쓰인다.

동전던지기를 예로 들면 베르누이 분포는 다음과 같이 되는데..

$$p(y|\theta) = \theta^y(1-\theta)^{(1-y)}$$

우리가 궁금한것은 모델이 주어졌을때의 샘플의 확률이 아니라, 거꾸로 샘플이 주어졌을때 어떤 모델($\theta$)이 적합한가이기 때문에, (ML적인 관점에선 당연하고 학습과정이 곧 이것)

거꾸로 $p(\theta|y)$에 관심이 있고 구해야하는 값이다.

그런데 베이즈 정리에 따르면

$P(\theta|y) = {{P(y|\theta)P(\theta)}\over{P(y)}}$가 되고, 다음과 같은 의미로 해석한다.

$$사후확률(posterior) = {{가능도(likelihood) \times 사전확률(prior)}\over{증거(evidence)}}$$

즉 우리가 학습을 한다는 것은 사후확률을 구한다고도 얘기할 수 있는데, 이때 베타함수 형태로 가정하면 식을 세우기 편하다고 직관적으로 보면 딱 좋을것 같다.

(즉 무조건 사후확률이 베타분포가 된다는게 아니라 베타분포로 가정한다는걸 이해하는게 중요)

베타함수는 두변수(x, y)에 대한 다변수 함수이며 다음과 같이 정의된다.

x>0, y>0일때

$$B(x, y) = \int_0^1 t^{x-1}(1-t)^{y-1}dt$$

보통 팩토리얼이 감마함수로 일반화 되듯이,

조합(Combination)의 일반화로 이야기 된다.

조합은 이항계수라고도 하고 n과 k가 자연수일때 다음과 같이 정의된다.

$$_nC_k = {n \choose k} = {{n!}\over{k!(n-k)!}}$$

보면 자연수일때도 팩토리얼이 들어가므로, 실수, 복소수로 확장하게 된다면 감마함수가 들어가는게 자연스러울 거란걸 알 수 있다.

베타함수는 감마함수를 쓰면 다음과 같이 된다.

$$B(x,y) = {{\Gamma(x)\Gamma(y)}\over{\Gamma(x+y)}}$$

근데 위 식을 보면은 감마함수의 경우는 팩토리얼과 아주 유사하게 되어 있는데 이항계수식과 베타함수를 보면 분모분자도 바뀌어 있는것 같고 뭔가 정확히 같아보이진 않는다.

실제로 m과n이 자연수일때 둘간의 관계를 나타내 보면 다음과 같이 서로 역수 형태임을 알 수 있다.

$$B(m,n) = {1\over{m\cdot _{m+n-1}C_{n-1}}}$$

$${n \choose k} = {1\over{(n+1)B(n-k+1,k+1)}}$$

| 베르누이 분포(bernoulli distribution) (1) | 2019.06.27 |

|---|---|

| 깁스 샘플링(Gibbs Sampling) (0) | 2019.06.26 |

| 카이제곱 검정(chi-squared test) (0) | 2019.06.21 |

| 정규분포 (1) | 2019.06.20 |

| 가설검정, 유의수준, 귀무가설, 대립가설, p-value(p값), t-test(t검정), z-test(z검정) (0) | 2019.04.26 |

가장 간단하게는 베이즈 정리를 사용하여 사후확률을 구하는 과정이라고 할 수 있다.

ML적인 관점에서는 보통 $p(모델|샘플)$을 구하는 과정이 된다.

(주어진 샘플을 가장 잘 설명하는 모델파라미터를 찾는 과정...)

문자를 써서 표시하면 $P(\theta|X) = {{P(X|\theta)P(\theta)}\over{P(X)}}$가 되고, 다음과 같은 의미로 해석한다.

$$사후확률(posterior) = {{가능도(likelihood) \times 사전확률(prior)}\over{증거(evidence)}}$$

사전확률 = 경험적으로 알고 있는 것

사후확률 = 관심있는 것

아래 예제는 여기서 발췌함

쿠키 가득한 그릇이 2 개 있다고하자. 그릇 # 1에는 10 개의 초콜릿 칩 쿠키와 30 개의 일반 쿠키가 그릇 # 2에는 각각 20 개씩있다 (이것을 전제 지식으로한다). 어느 하나의 그릇을 무작위로 선택하고 또한 무작위로 쿠키를 꺼낸다. 결과 쿠키는 일반이었다. 이것이 그릇 # 1에서 꺼내 진이라는 확률은 어느 정도인가?

절반 이상이라는 것은 직관적으로 알 수있다 (그릇 # 1 분이 일반 쿠키가 많기 때문). 정확한 답변을 베이지안 추정 내자. 그릇 # 1을 선택하는 이벤트를 H 1 그릇 # 2를 선택하는 이벤트를 H 2 로한다.

먼저 그릇을 무작위로 선택 했으니 그 둘 중 하나를 취할 확률은 P ( H 1 ) = P ( H 2 ) = 0.5.

"일반 쿠키가 나왔다"는 관찰 결과를 "데이터 D "로한다. 그릇 # 1에서 D 확률은 P ( D | H 1 ) = 30/40 = 0.75 그릇 # 2는 P ( D | H 2 ) = 20/40 = 0.5로 나타났다. 베이지안 식은

이되기 때문 쿠키를보기 전에 그릇 # 1을 선택 확률 (사전 확률)는 P ( H 1 ) = 0.5. 쿠키를 본 후에는이 확률은 P ( H 1 | D ) = 0.6로 개정된다.

관찰 결과가 성공 m 번 실패 n 시간이되었다고한다. 구체적으로는 동전 던지기 에도 누군가에 찬성 · 반대의 의견을 듣는 것도 좋다. 모수 a (시도 횟수, 성공 확률)에 대한 사전 확률 p ( a )에서 표현한다.

주어진 a 의 값에 대한 전체 m + n 회 시행의 내 성공이 m 시간이 될 확률은

m 및 n 은 고정되고, a 는 불명하기 때문에 이것은 a 의 가능도된다.

베이 즈 정리 (연속 분포의 형태)에서

사전 분포 p ( a )로 특정 물건을 선택하면,이 적분을 수행 할 수 사후 확률은 간단한 형태가된다.

특히 p ( a )가 모수 m 0 과 n 0 의 베타 분포 라면, 사후 분포도 베타 분포에서 모수는 m + m 0 과 n + n 0 이된다.

위의 예 베타 분포처럼 사후 분포가 동일한 유형의 분포가되도록 사전 분포를 공액 사전 분포 한다.

베이즈 정리와 추론이 있는데 정리는 여기 참조.

베이즈 추론을 알려면 베르누이 분포와 베타분포를 먼저 알아야 함

| 수학관련 유용한 사이트 (0) | 2024.01.27 |

|---|---|

| 모듈러연산 (0) | 2020.04.04 |

| Bootstrap Sampling(부트스트랩 샘플링) (0) | 2019.02.08 |

| 공분산(Covariance)과 상관계수(Correlation Coefficient) (0) | 2019.01.18 |

| 확률변수(random variable) (0) | 2019.01.18 |

MLE의 경우를 생각해보면 우리는 샘플들을 보고 그 샘플들을 가장 잘 설명하는 모델을 찾아나가게 된다.

MLE가 아니라 전반적인 ML이란 것 자체가 샘플(학습인풋)들을 보고 그 샘플을 가장 잘 설명하는 모델(딥러닝 웨이트 등)을 찾는 과정이라는 점에서 동일함을 알 수 있다.

근데 이 샘플을 주어진 샘플을 사용하는게 아니라 generation해야 한다고 생각해보면 어떻게 될까?

예를 들어 $\pi$를 구하는 몬테카를로의 경우 사각영역안에서 uniform random으로 좌표를 찍어서 샘플링을 하게된다.

이런 uniform random sampling의 경우는 간단한데..

uniform하지 않고 특정 확률분포를 따르는 경우는 복잡해지기 시작한다.

그리고 샘플이 보통 1차원이 아니라 n차원이 되는데(딥러닝 인풋이 n개면 n차원으로 볼 수 있다)

이런경우에 각각의 차원이 별도의 확률분포를 가지는 경우 샘플링이 상당히 힘들어지게 된다.

깁스 샘플링은 이러한 경우에 한번에 하나의 차원씩 샘플링하면서 만들어 나가는 방법론인걸로 일단 파악중이다.

(자세한건 전혀 모름)

| 베르누이 분포(bernoulli distribution) (1) | 2019.06.27 |

|---|---|

| 베타함수, 베타분포 (0) | 2019.06.27 |

| 카이제곱 검정(chi-squared test) (0) | 2019.06.21 |

| 정규분포 (1) | 2019.06.20 |

| 가설검정, 유의수준, 귀무가설, 대립가설, p-value(p값), t-test(t검정), z-test(z검정) (0) | 2019.04.26 |

단일변수에 대한 z검정 또는 t검정은 귀무가설과 대립가설을 세우고, 표준정규분포 또는 t분포와 p-value를 통해서 유의성을 검증하는데,

아래와 같이 두 변수의 연관성에 대한 검증을 할때는, 정규분포 또는 t분포가 아닌 카이제곱분포를 따르는것이 알려져 있으며,

카이제곱 검정을 이해하기 위해서는 카이분포를 먼저 이해해야 한다.

카이분포를 이해하기 위해서는 정규분포와 감마분포를 이해해야 한다.

감마분포는 아래 감마함수와 연관되어 있고, 팩토리얼을 실수 및 복소수까지 일반화한 바로 그 함수이다.

감마분포는 확률밀도함수 형태여야 하므로 감마함수에서 전체 적분값이 1.0이 되도록 맞춰주면 나온다.

근데, 정규분포에서 평균m과 표준편차 $\sigma$가 파라미터로 추가되듯, 여기서도 감마분포의 특성을 고려해 알파,베타 파라미터를 추가하면 다음과 같다.

위처럼 감마분포는 보통 x>0 인 구간에 대해서만 사용하는 것 같다. (정규분포는 모든 x구간 사용)

파이선에서 알파,베타를 바꿔가면서 감마분포를 그려보면 다음과 같다 (scipy.stat의 gamma.pdf 사용)

$\beta$가 커질수록 그래프는 더 퍼지는 형태를 띠게 되고, $\alpha$가 커질수록 bell shape에 가까운 모양이 됨을 알 수 있다.

카이제곱분포는 감마분포에서 , β= 2로 고정한 특별한 경우이다 .

자유도가 r인 카이제곱분포는 감마분포 $\Gamma({r\over 2},2)$에 해당되며, 확률밀도함수는 다음과 같다.

* 감마분포의 자연스러운 사용 예제

* 카이제곱검정에서 셀을통한 계산을 하면 카이제곱분포의 x값이 나오는 정확한 이유

| 베르누이 분포(bernoulli distribution) (1) | 2019.06.27 |

|---|---|

| 베타함수, 베타분포 (0) | 2019.06.27 |

| 깁스 샘플링(Gibbs Sampling) (0) | 2019.06.26 |

| 정규분포 (1) | 2019.06.20 |

| 가설검정, 유의수준, 귀무가설, 대립가설, p-value(p값), t-test(t검정), z-test(z검정) (0) | 2019.04.26 |

동의어: 가우시안 분포

여기좋다.

본 글은 따라가다 보면 정규분포가 자연스럽게 이해되도록 의식의 흐름대로 작성되었습니다.

먼저 다음 함수를 보자

$f(x) = e^{-x^2}$

매개변수 a는 곡선의 꼭대기 높이가 되며, b는 꼭대기의 중심의 위치가 된다. c는 종의 너비를 결정한다.

여기서 평균과 표준편차와 관련되도록 다음처럼 a,b,c값을 살짝 살짝 또 만져주면서 대입하면 드디어 정규분포에 관련된 함수가 된다.

$f(x)=\frac 1 {\sqrt{2\pi} \sigma} e^{-\frac {(x-m)^2 }{2\sigma^2}}$

좀더 정확히는 정규분포를 따르는 확률변수의 확률밀도함수이다. (대충 넘어가자)

확률밀도 함수이므로 적분값이 1.0이 되도록 살짝 살짝 만진것이다.

정규분포를 따르는 예시에 대해서는 여기를 참조하자(동전, 주사위 등)

표준정규분포 = 평균이 0이고 표준편차가 1인 정규분포(위 식에서 평균에 0, 표준편차에 1을 대입하면 된다.)

$f(x)=\frac 1 {\sqrt{2\pi} } e^{-\frac {x^2 }{2}}$

| 베르누이 분포(bernoulli distribution) (1) | 2019.06.27 |

|---|---|

| 베타함수, 베타분포 (0) | 2019.06.27 |

| 깁스 샘플링(Gibbs Sampling) (0) | 2019.06.26 |

| 카이제곱 검정(chi-squared test) (0) | 2019.06.21 |

| 가설검정, 유의수준, 귀무가설, 대립가설, p-value(p값), t-test(t검정), z-test(z검정) (0) | 2019.04.26 |

귀무가설(H0)이란 관습적이고 보수적인 주장, 통념.

대립가설(H1)이란 귀무가설과 반대 주장, 때에 따라 우리가 입증하려는 주장이 된다.

신뢰수준(=신뢰도) : 귀무가설을 선택할수 있는 수준( 0 ~ 100% )

유의수준($\alpha$): 귀무가설을 기각할 수 있는 수준 ( 0 ~ 100%), 둘이 더하면 항상 100%(=1.0)가 된다.

예를 들어, 신뢰수준 90%라면 유의수준은 10% 즉 0.1이 된다.

신뢰도나 유의수준은 실험자가 임의로 정하는 값이다.

예를 들면, 샘플링한 데이터가 신뢰도95%에서 유의미한지 검정하겠다. 라고 정하는 식이다.

즉, 일종의 threshold 개념이고, 신뢰수준이 아닌 유의수준에서 설정한 이 threshold를 알파라고 부른다.

신뢰도95%라면 유의수준은 5%이므로 $\alpha$는 0.05가 된다.

p-value는 귀무가설이 맞다는 전제하에 관측된 통계값 보다 더 희귀할 확률을 의미한다.

따라서 p-value가 너무 낮다면 그렇게 낮은 확률이 실제로 일어났다고 생각하기 보다는 귀무가설이 틀렸다고 생각하게 된다.

그래서 귀무가설을 기각하고 대립가설을 채택하게 된다.

여기서 통계값이란, 관측된 샘플데이터에 대해서 일종의 표준편차를 구하는 작업으로, 다음과 같이 구한다.

정규분포 t분포

즉, 다시 정리하면

유의수준($\alpha$) 은 실험자가 선정한 스레시홀드이며,

유의확률(p-value)이란 관측된 샘플데이터를 바탕으로 구한 값으로, 낮을수록 엄밀하지 않게는 귀무가설이 틀리고, 대립가설이 맞을 확률이 높다고 해석할 수 있다.

(즉 실험자가 원하는 것이 대립가설의 검정이라면 p-value가 낮으면 낮을수록 우연이 아닌것이 되므로 좋다)

자료로부터 얻은 p값 < 유의확률($\alpha$) 이라라면 해당 귀무가설을 기각(타파)할 수 있으며 가설검정 성공

A나라의 평균수명은 70세라고 통상 알려져 있습니다. 실제로 평균 수명이 70세인지 아닌지 검정하고 싶습니다.

Q) 귀무가설과 대립가설은?

A)

귀무가설: A나라의 평균수명의 통념대로 70세 이다.

대립가설: A나라의 실제로 평균 수명이 70세가 아니다.

(이때 대립가설을 70세가 아니다 라고만 하면 양방향, 70세 초과다 또는 70세 미만이다 라고 하면 한방향이 된다.)

Q) 샘플링한 데이터를 t-test를 진행한 결과 p-value가 0.04로 나왔습니다.

유의수준 5%에서 검정하세요.

A)

대립가설채택근거는 t-test (두 집단의 평균 차이 확인시 사용)결과 p-value = 0.04로

유의확율인 0.05보다 작아 귀무가설은 기각하고, 대립가설을 채택할 수 있다.

위에 설명은 표본이 실제 모집단의 정규분포를 따른다는 가정을 하고 있는데, 실제로는 정규분포가 아니라 t-분포를 따른다고 한다.

그리고 당연히 샘플수가 많아지면 많아질수록 정규분포에 가까워지기는 한다.

t분포의 특성

1) t분포는 표준정규분포처럼 0을 중심으로 종형의 모습을 가진 대칭 분포이다.

2) t분포의 꼬리는 표준정규분포보다 두껍다(fat tail).

3) t분포는 자유도 n에 따라 모습이 변하는데, 자유도 n이 커짐에 따라 표준정규분포 N(0,1)에 수렴한다.

통계적 추론에서는 통상 모집단의 분산이 알려져 있지 않은 경우, 표분분포를 결정할 때 표본의 크기가 30 이하이면 t분포를, 그 크기가 30 이상이면 표준정규분포를 이용한다고 하는데, 이는 바로 위에서 설명된 특성 3) 때문이다.

| 베르누이 분포(bernoulli distribution) (1) | 2019.06.27 |

|---|---|

| 베타함수, 베타분포 (0) | 2019.06.27 |

| 깁스 샘플링(Gibbs Sampling) (0) | 2019.06.26 |

| 카이제곱 검정(chi-squared test) (0) | 2019.06.21 |

| 정규분포 (1) | 2019.06.20 |

어떤 배열이 있을때 중복을 허용하여 n개를 sampling할 때 이를 sampling with repliacement라고 하며, 이때 생성된 sampling 배열을 bootstrap이라고 한다.

예를 들어 [A, B, C, D, E]란 배열이 있고 중복을 허용하여 7개를 sampling 한다고 하면

[A, C, D, A, E, E, B] 와 같은 배열이 만들어 질것이고 이 배열을 bootstrap이라고 한다는 것

통계적으로는 평균의 신뢰도구간등을 측정하는 등의 용도로 쓸 수 있고,

ML측면에서는 모델 개수를 늘려서 오버피팅을 피하는 앙상블을 하기 좋다는 측면이 있다.

| 모듈러연산 (0) | 2020.04.04 |

|---|---|

| 베이즈 추론(Bayesian inference) (0) | 2019.06.27 |

| 공분산(Covariance)과 상관계수(Correlation Coefficient) (0) | 2019.01.18 |

| 확률변수(random variable) (0) | 2019.01.18 |

| 직교행렬(orthogonal matrix) (0) | 2019.01.09 |