여기, 여기, 여기, 여기 참조했음

개요

귀무가설(H0)이란 관습적이고 보수적인 주장, 통념.

대립가설(H1)이란 귀무가설과 반대 주장, 때에 따라 우리가 입증하려는 주장이 된다.

신뢰수준(=신뢰도) : 귀무가설을 선택할수 있는 수준( 0 ~ 100% )

유의수준($\alpha$): 귀무가설을 기각할 수 있는 수준 ( 0 ~ 100%), 둘이 더하면 항상 100%(=1.0)가 된다.

예를 들어, 신뢰수준 90%라면 유의수준은 10% 즉 0.1이 된다.

신뢰도나 유의수준은 실험자가 임의로 정하는 값이다.

예를 들면, 샘플링한 데이터가 신뢰도95%에서 유의미한지 검정하겠다. 라고 정하는 식이다.

즉, 일종의 threshold 개념이고, 신뢰수준이 아닌 유의수준에서 설정한 이 threshold를 알파라고 부른다.

신뢰도95%라면 유의수준은 5%이므로 $\alpha$는 0.05가 된다.

p-value는 귀무가설이 맞다는 전제하에 관측된 통계값 보다 더 희귀할 확률을 의미한다.

따라서 p-value가 너무 낮다면 그렇게 낮은 확률이 실제로 일어났다고 생각하기 보다는 귀무가설이 틀렸다고 생각하게 된다.

그래서 귀무가설을 기각하고 대립가설을 채택하게 된다.

여기서 통계값이란, 관측된 샘플데이터에 대해서 일종의 표준편차를 구하는 작업으로, 다음과 같이 구한다.

정규분포 t분포

.

.

즉, 다시 정리하면

유의수준($\alpha$) 은 실험자가 선정한 스레시홀드이며,

유의확률(p-value)이란 관측된 샘플데이터를 바탕으로 구한 값으로, 낮을수록 엄밀하지 않게는 귀무가설이 틀리고, 대립가설이 맞을 확률이 높다고 해석할 수 있다.

(즉 실험자가 원하는 것이 대립가설의 검정이라면 p-value가 낮으면 낮을수록 우연이 아닌것이 되므로 좋다)

자료로부터 얻은 p값 < 유의확률($\alpha$) 이라라면 해당 귀무가설을 기각(타파)할 수 있으며 가설검정 성공

z-test(z검정) 예제

A나라의 평균수명은 70세라고 통상 알려져 있습니다. 실제로 평균 수명이 70세인지 아닌지 검정하고 싶습니다.

Q) 귀무가설과 대립가설은?

A)

귀무가설: A나라의 평균수명의 통념대로 70세 이다.

대립가설: A나라의 실제로 평균 수명이 70세가 아니다.

(이때 대립가설을 70세가 아니다 라고만 하면 양방향, 70세 초과다 또는 70세 미만이다 라고 하면 한방향이 된다.)

Q) 샘플링한 데이터를 t-test를 진행한 결과 p-value가 0.04로 나왔습니다.

유의수준 5%에서 검정하세요.

A)

대립가설채택근거는 t-test (두 집단의 평균 차이 확인시 사용)결과 p-value = 0.04로

유의확율인 0.05보다 작아 귀무가설은 기각하고, 대립가설을 채택할 수 있다.

t-test(t검정)

위에 설명은 표본이 실제 모집단의 정규분포를 따른다는 가정을 하고 있는데, 실제로는 정규분포가 아니라 t-분포를 따른다고 한다.

그리고 당연히 샘플수가 많아지면 많아질수록 정규분포에 가까워지기는 한다.

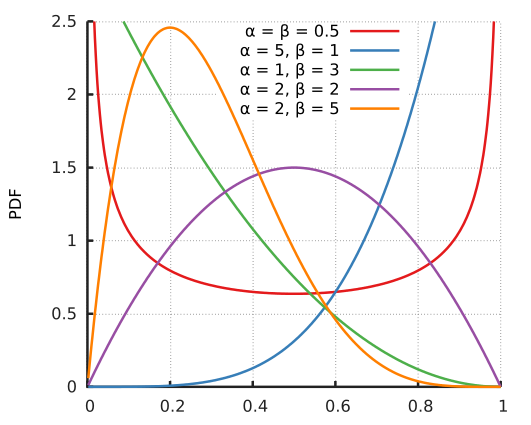

t분포의 특성

1) t분포는 표준정규분포처럼 0을 중심으로 종형의 모습을 가진 대칭 분포이다.

2) t분포의 꼬리는 표준정규분포보다 두껍다(fat tail).

3) t분포는 자유도 n에 따라 모습이 변하는데, 자유도 n이 커짐에 따라 표준정규분포 N(0,1)에 수렴한다.

통계적 추론에서는 통상 모집단의 분산이 알려져 있지 않은 경우, 표분분포를 결정할 때 표본의 크기가 30 이하이면 t분포를, 그 크기가 30 이상이면 표준정규분포를 이용한다고 하는데, 이는 바로 위에서 설명된 특성 3) 때문이다.